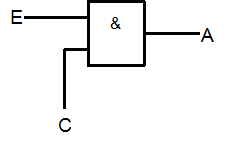

| E | C | A |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 0 |

| 1 | 0 | 0 |

| 1 | 1 | 1 |

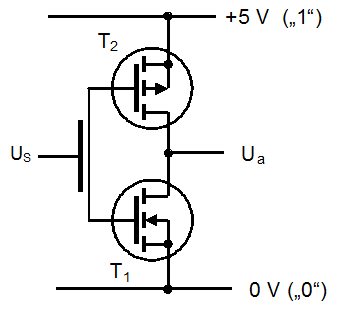

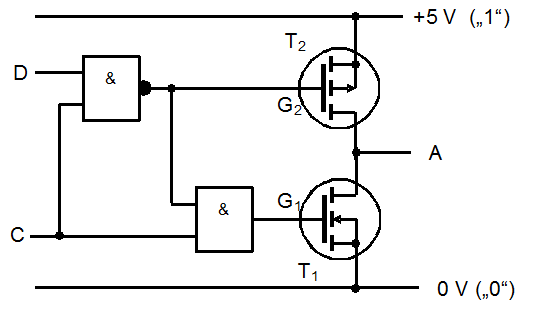

| D | C | G2 | G1 | A |

|---|---|---|---|---|

| 0 | 0 | 1(s) | 0(s) | Hi-Z |

| 1 | 0 | 1(s) | 0(s) | Hi-Z |

| 0 | 1 | 1(s) | 1(l) | 0 |

| 1 | 1 | 0(l) | 0(s) | 1 |

| E1 | E2 | NOR |

|---|---|---|

| 0 | 0 | 1 |

| 0 | 1 | 0 |

| 1 | 0 | 0 |

| 1 | 1 | 0 |

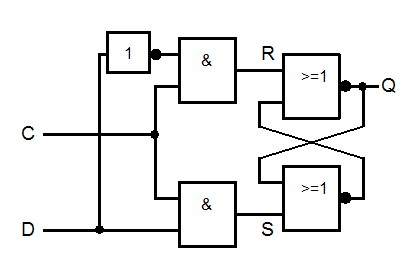

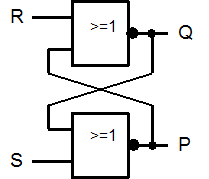

| t | R | S | Q | P |

|---|---|---|---|---|

| 0 | 0 | 0 | * | * |

| 1 | 1 | 0 | 0 | 1 |

| t | R | S | Q | P |

|---|---|---|---|---|

| 0 | 0 | 0 | * | * |

| 1 | 1 | 0 | 0 | 1 |

| 2 | 0 | 0 | 0 | 1 |

| t | R | S | Q | P |

|---|---|---|---|---|

| 0 | 0 | 0 | * | * |

| 1 | 1 | 0 | 0 | 1 |

| 2 | 0 | 0 | 0 | 1 |

| 3 | 0 | 1 | 1 | 0 |

| 4 | 0 | 0 | 1 | 0 |